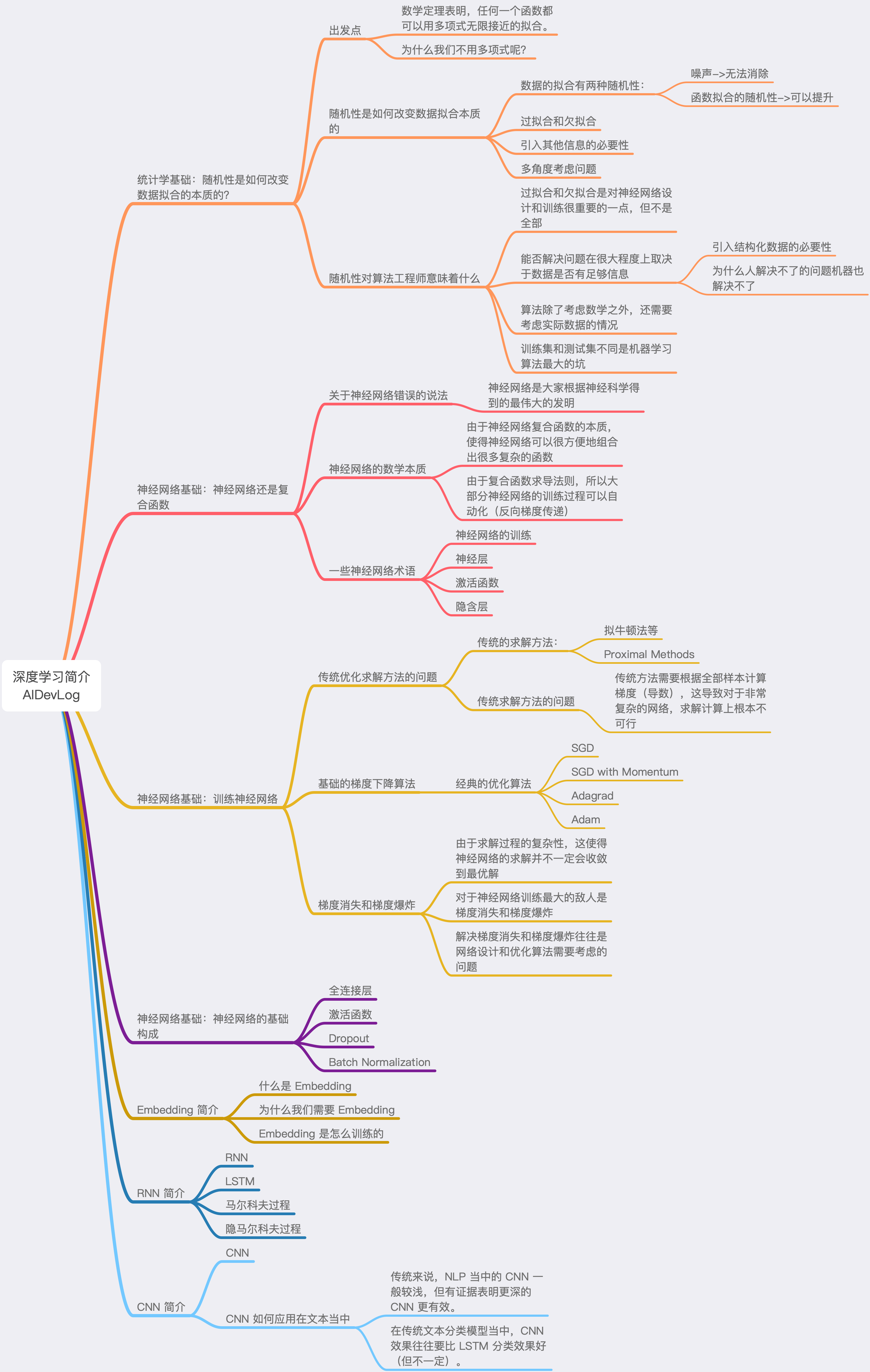

统计学基础:随机性是如何改变数据拟合的本质的?

出发点

数学定理表明,任何一个函数都可以用多项式无限接近的拟合。

为什么我们不用多项式呢?

随机性是如何改变数据拟合本质的

数据的拟合有两种随机性:

噪声->无法消除

函数拟合的随机性->可以提升

过拟合和欠拟合

引入其他信息的必要性

多角度考虑问题

随机性对算法工程师意味着什么

过拟合和欠拟合是对神经网络设计和训练很重要的一点,但不是全部

能否解决问题在很大程度上取决于数据是否有足够信息

引入结构化数据的必要性

为什么人解决不了的问题机器也解决不了

算法除了考虑数学之外,还需要考虑实际数据的情况

训练集和测试集不同是机器学习算法最大的坑

神经网络基础:神经网络还是复合函数

关于神经网络错误的说法

- 神经网络是大家根据神经科学得到的最伟大的发明

神经网络的数学本质

由于神经网络复合函数的本质,使得神经网络可以很方便地组合出很多复杂的函数

由于复合函数求导法则,所以大部分神经网络的训练过程可以自动化(反向梯度传递)

一些神经网络术语

神经网络的训练

神经层

激活函数

隐含层

神经网络基础:训练神经网络

传统优化求解方法的问题

传统的求解方法:

拟牛顿法等

Proximal Methods

传统求解方法的问题

- 传统方法需要根据全部样本计算梯度(导数),这导致对于非常复杂的网络,求解计算上根本不可行

基础的梯度下降算法

经典的优化算法

SGD

SGD with Momentum

Adagrad

Adam

梯度消失和梯度爆炸

由于求解过程的复杂性,这使得神经网络的求解并不一定会收敛到最优解

对于神经网络训练最大的敌人是梯度消失和梯度爆炸

解决梯度消失和梯度爆炸往往是网络设计和优化算法需要考虑的问题

神经网络基础:神经网络的基础构成

全连接层

激活函数

Dropout

Batch Normalization

Embedding 简介

什么是 Embedding

为什么我们需要 Embedding

Embedding 是怎么训练的

RNN 简介

RNN

LSTM

马尔科夫过程

隐马尔科夫过程

CNN 简介

CNN

CNN 如何应用在文本当中

传统来说,NLP 当中的 CNN 一般较浅,但有证据表明更深的 CNN 更有效。

在传统文本分类模型当中,CNN 效果往往要比 LSTM 分类效果好(但不一定)。