图像传感器的工作原理1

CMOS sensor内部结构2

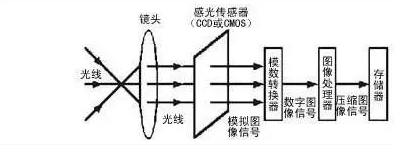

图像传感器是一种半导体装置,能够把光学影像转化为数字信号。传感器上植入的微小光敏物质称作像素。一块传感器上包含的像素数越多,其提供的画面分辨率也就越高。它的作用就像胶片一样,但它是把图像像素转换成数字信号。

CMOS Sensor 基础知识3

CMOS Parallel Sensor 一些基础知识

1S秒 = 1000 ms毫秒 = 1000_1000 us微妙 = 1000_000_000 ns纳秒

1GHz = 1000 MHz = 1000_000 KHz = 1000_000_000 Hz

曝光时间以行长为单位; PCLK以Hz为单位;

行长以周期数为单位,帧长以行长数为单位;其中周期数就是频率

T 周期以ms为单位;f 频率以Hz为单位;f = 1 / T;周期和频率都是时间单位,只是表现形式不同

Vsync = Dummy Line = VTotal = VTS = V_Size + V_Blank // 帧长; 不占用曝光时间,但是会影响帧率(FPS)

Hsync = Dummy Pixel = HTotal = HTS = H_Size + H_Blank // 行长; 会增加曝光时间,会影响帧率(FPS)

FPS = PCLK / (VTS * HTS )// 计算FPS

T_Row = HTS / PCLK // INT_Time 等于 1 的时候,此公式表示一行的曝光时间。

Exp = T_Row * INT_Time // INT_Time 积分时间(曝光时间寄存器)

- 计算FPS可以通过修改 V_Total, H_Total 或者 降低 PCLK频率(当HTS or VTS降低到极限之后,需要通过降低PCLK来达到降FPS的目的) 达到降帧的目的。

- Ob = Black Level 暗电流

- AE 主要控制Sensor Exp & Gain 这两种寄存器

- Sensor自带ISP,Mirror,Flip,WDR不做多的讲解

CMOS MIPI Sensor

看数据线对数可以知道是N Lane 的Sensor

CMOS Sub-LVDS Sensor

看数据线对数可以知道是N Lane 的Sensor

CMOS Hispi

- integration time 积分时间

当光源周期与integration time成整数倍时才不会产生flicker

integration time即积分时间是以行为单位表示曝光时间(exposure time)的,比如说INT TIM为159,就是指sensor曝光时间为159行,

两者所代表的意思是相同的,都是表示sensor的曝光时间,但是integration time是一个相对的概念,即以行为单位,而每行所占的绝对时间与pclk的时钟频率和每一行包含多少pclk(即行长)有关;而exposure time则是指sensor曝光的绝对时间,两者换算的关系如下:

exposure time = integration time x 行长 /pclk 频率

光源周期应该理解为光源能量周期,是交流电周期的两倍(如交流电频率为50hz,则光源能量周期为0.01s),步长所占绝对时间与光源能量周期相等。

flicker有两种情况,一种是逐行复位积分产生的,即帧内flicker,显示时图像出现明暗行交替的现象,主要是因为一帧内不同行虽然int tim 一致,但是因为积分起始位置不一样,且室内人工光源的发光强度与交流电的频率呈周期关系,导致不同行的受光量不一致,从而产生这种明暗行交替的现象,而且如果一帧所占时间不为光源能量周期的整数倍,可观察到flicker不稳定,明暗行的相对位置不断是变化的,就好像暗行在不断向上移动一样,如果能保证一帧所占绝对时间为光源能量周期的整数倍,filiker就可以稳定下来;

另一种情况是整帧复位积分方式产生的,即视频浏览时,帧间闪烁,即不同帧明暗不一致,目前其消除方法是通过调节glb gain值来改善

GLB GAIN就是全局增益,是调节图像的整体亮度的GAIN值,而R/B/G GAIN是AWB中用到的概念,针对三原色分别进行调节,是为了调整色偏用的

sensor 输出分为四种

- YUV

- "Y"表示明亮度(Lumina nce或Luma),也就是灰度值

- "U"和"V"表示的则是色度(Chrominance或Chroma),作用是描述影像色彩及饱和度,用于指定像素的颜色。

- 存储格式

- planar (平面)先连续存储所有像素点的Y

- packed (打包)连续交叉存储

- 采样

- YUV4:4:4

- YUV4:2:2

- YUV4:2:0

- raw RGB

- RGB

- RGB565

- 每个像素用16位表示,RGB分量分别使用5位、6位、5位(常用也就是上说的RGB)

- RGB555

- 每个像素用16位表示,RGB分量都使用5位(剩下1位不用)

- RGB24

- 每个像素用24位表示,RGB分量各使用8位

- RGB32

- 每个像素用32位表示,RGB分量各使用8位(剩下8位不用)

- ARGB32

- 每个像素用32位表示,RGB分量各使用8位(剩下的8位用于表示Alpha通道值)

- RGB565

- JPEG

六大硬件技术指标

- 像素

- 靶面尺寸

- 感光度

- 电子快门

- 帧率

- 信噪比

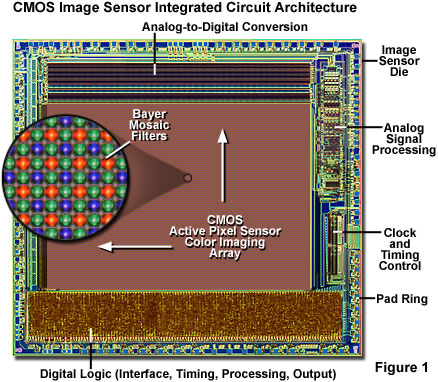

图像传感器整体架构

CMOS图像传感器本质是一块芯片,主要包括:感光区阵列(Bayer阵列,或叫像素阵列)、时序控制、模拟信号处理以及模数转换等模块。

- 像素阵列:

- 完成光电转换,将光子转换为电子。

- 时序控制:

- 控制电信号的读出、传递。

- 模拟信号处理(ADC):

- 对信号去噪。(如用CDS去除reset noise、fpn等)

CMOS传感器示例

其中,像素阵列占整个芯片的面积最大,像素阵列是由一个个像素组成,它对应到我们看到每张图片中的每个像素。

每个像素包括感光区和读出电路,每个像素的信号经由模拟信号处理后,交由ADC进行模数转换后即可输出到数字处理模块。

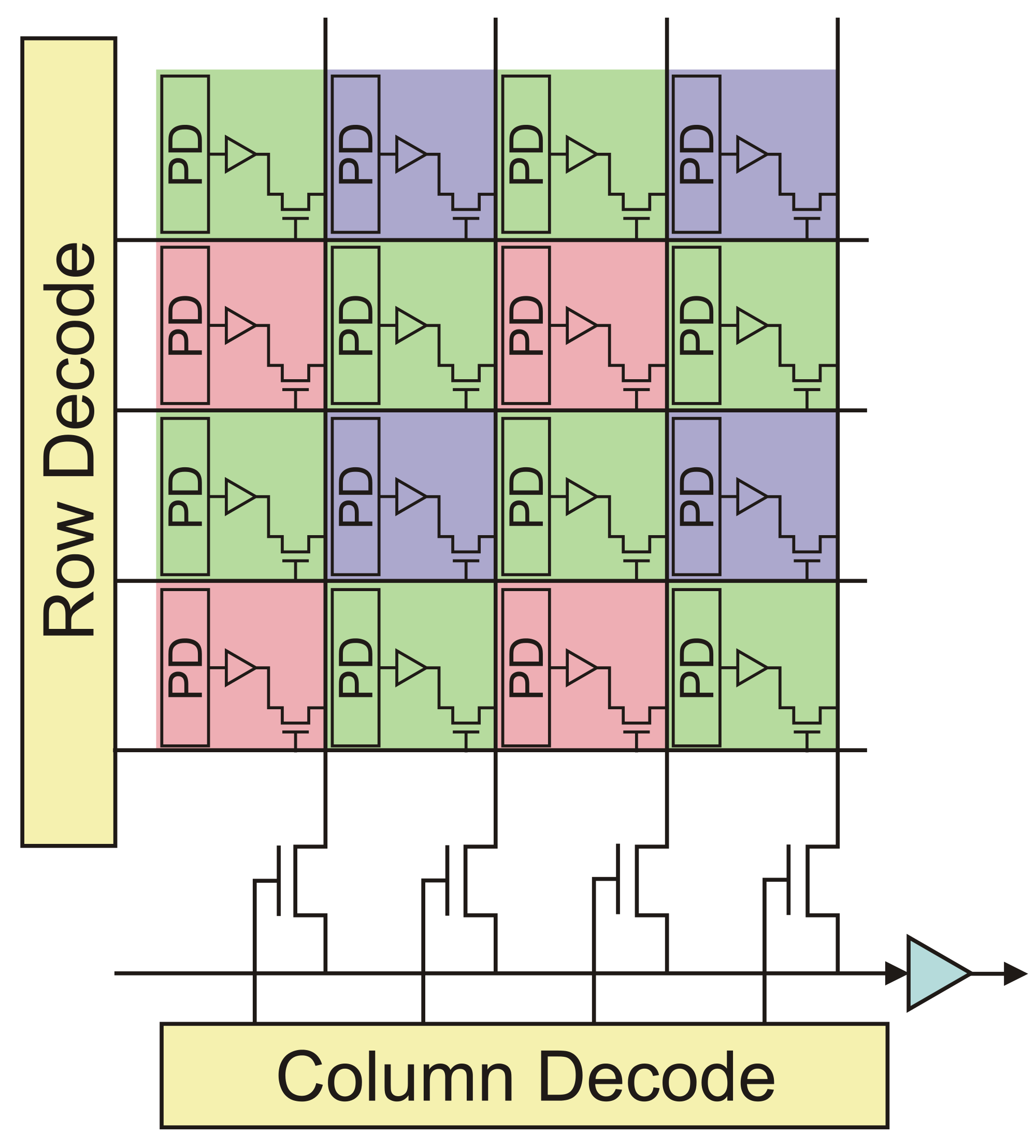

像素阵列的信号读出如下:

- 每个像素在进行reset,进行曝光。

- 行扫描寄存器,一行一行的激活像素阵列中的行选址晶体管。

- 列扫描寄存器,对于每一行像素,一个个的激活像素的列选址晶体管。

- 读出信号,并进行放大。

CMOS传感器信号读出示意图

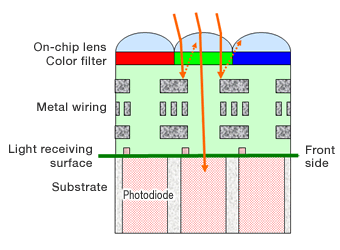

图像传感器像素结构4

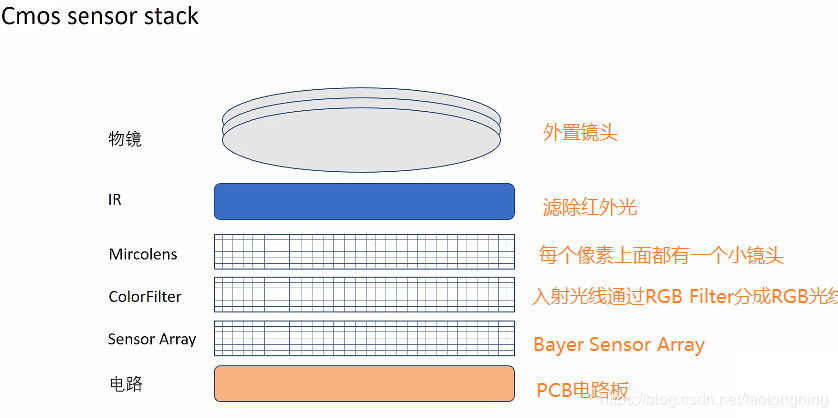

CMOS传感器上的主要部件是像素阵列,这是其与传统芯片的主要区别。每个像素的功能是将感受到的光转换为电信号,通过读出电路转为数字化信号,从而完成现实场景数字化的过程。像素阵列中的每个像素结构是一样的,如图2.1是典型的前照式像素结构,其主要结构包括:

On-chip-lens:- 该结构可以理解为在感光元件上覆盖的一层微透镜阵列,它用来将光线聚集在像素感光区的开口上。可以增加光电转化效率,减少相邻像素之间的光信号串扰。

Color filter:- 该结构是一个滤光片,包括红/绿/蓝三种,分别只能透过红色、绿色、蓝色对应波长的光线。该滤光片结构的存在,使得每个像素只能感应一种颜色,另外的两种颜色分量需要通过相邻像素插值得到,即demosaic算法。

Metal wiring:- 可以为金属排线,用于读出感光区的信号(其实就是像素内部的读出电路)。

Photodiode:- 即光电信号转换器,其转换出的电信号会经过金属排线读出。

像素结构