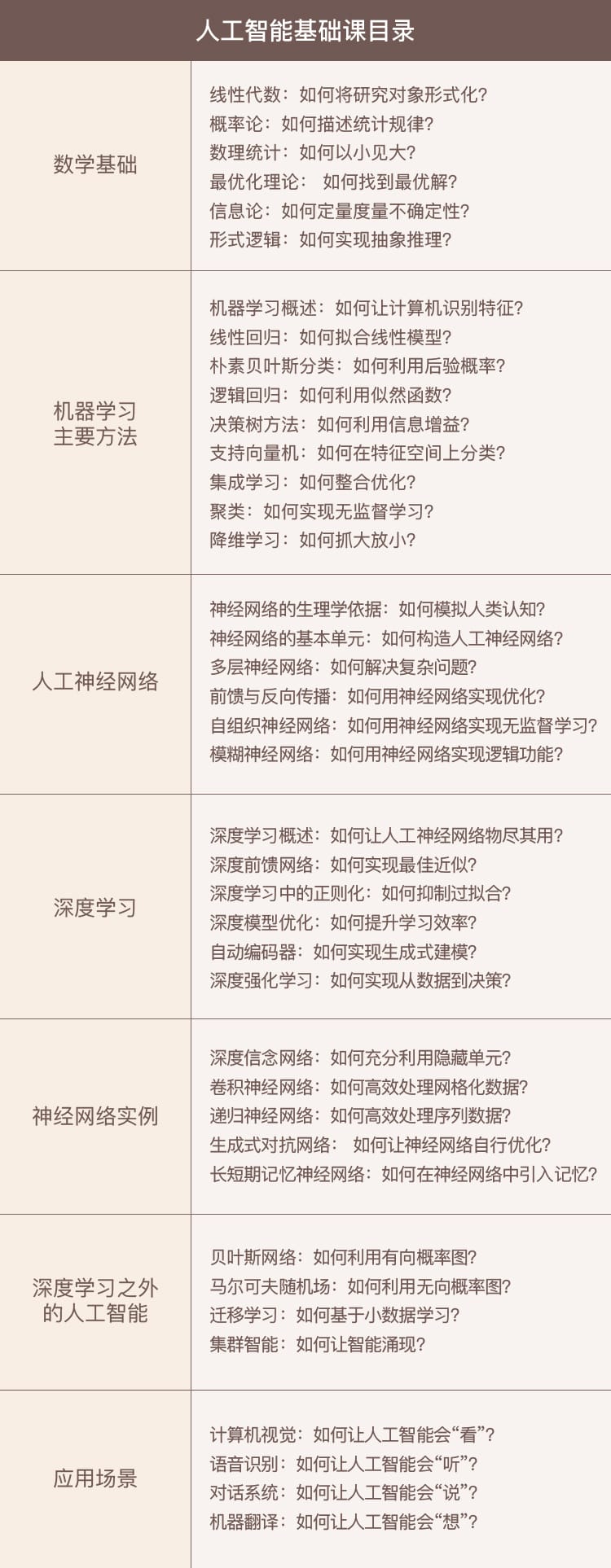

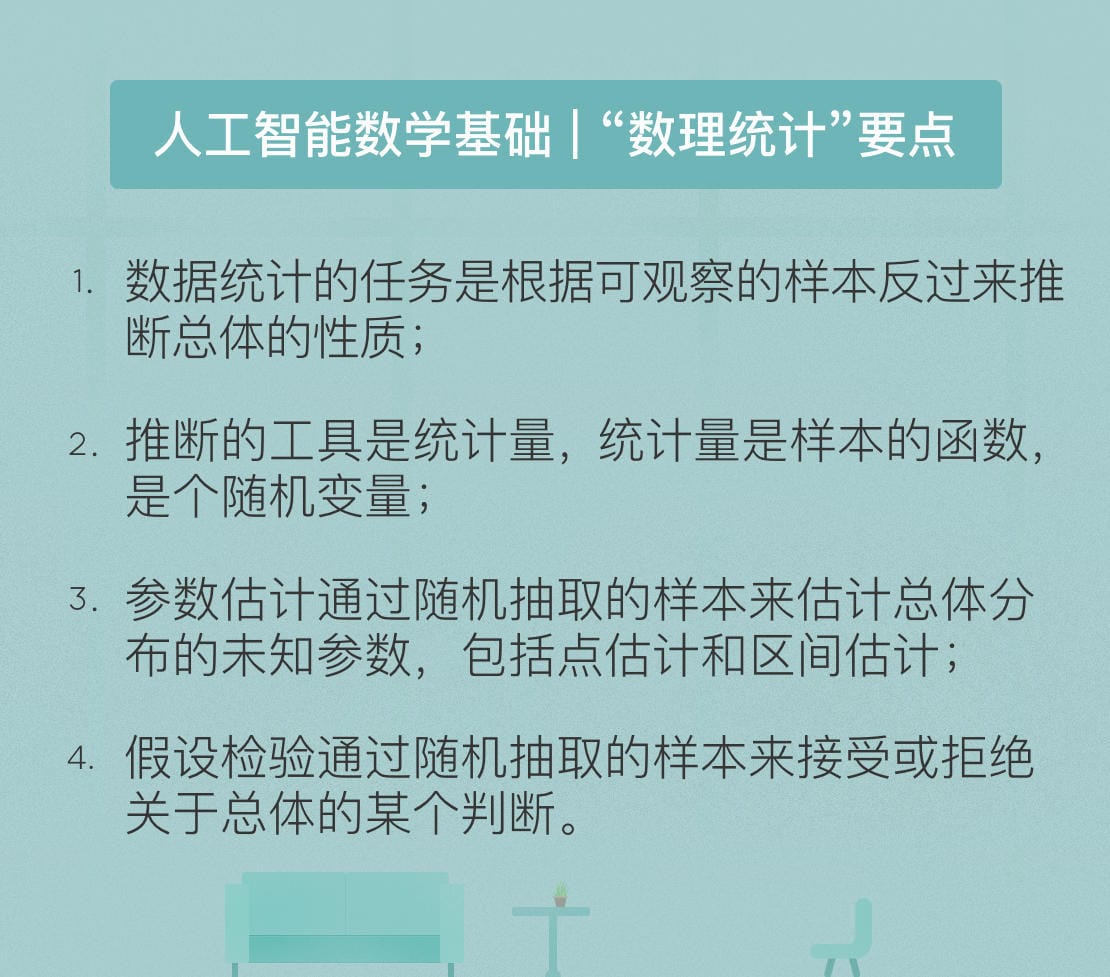

九层之台,起于累土:线性代数

必备的数学知识是理解人工智能不可或缺的要素,今天的种种人工智能技术归根到底都建立在数学模型之上,而这些数学模型又都离不开线性代数(linear algebra)的理论框架。

在线性代数中,由单独的数 a 构成的元素被称为标量(scalar):一个标量 a 可以是整数、实数或复数。如果多个标量按一定顺序组成一个序列,这样的元素就被称为向量(vector)。显然,向量可以看作标量的扩展。原始的一个数被替代为一组数,从而带来了维度的增加,给定表示索引的下标才能唯一地确定向量中的元素。

相对于向量,矩阵同样代表了维度的增加,矩阵中的每个元素需要使用两个索引(而非一个)确定。同理,如果将矩阵中的每个标量元素再替换为向量的话,得到的就是张量(tensor)。直观地理解,张量就是高阶的矩阵。

在计算机存储中,标量占据的是零维数组;向量占据的是一维数组,例如语音信号;矩阵占据的是二维数组,例如灰度图像;张量占据的是三维乃至更高维度的数组,例如 RGB 图像和视频。

线性代数的本质在于将具体事物抽象为数学对象,并描述其静态和动态的特性;

向量的实质是 n 维线性空间中的静止点;

线性变换描述了向量或者作为参考系的坐标系的变化,可以用矩阵表示;

矩阵的特征值和特征向量描述了变化的速度与方向。

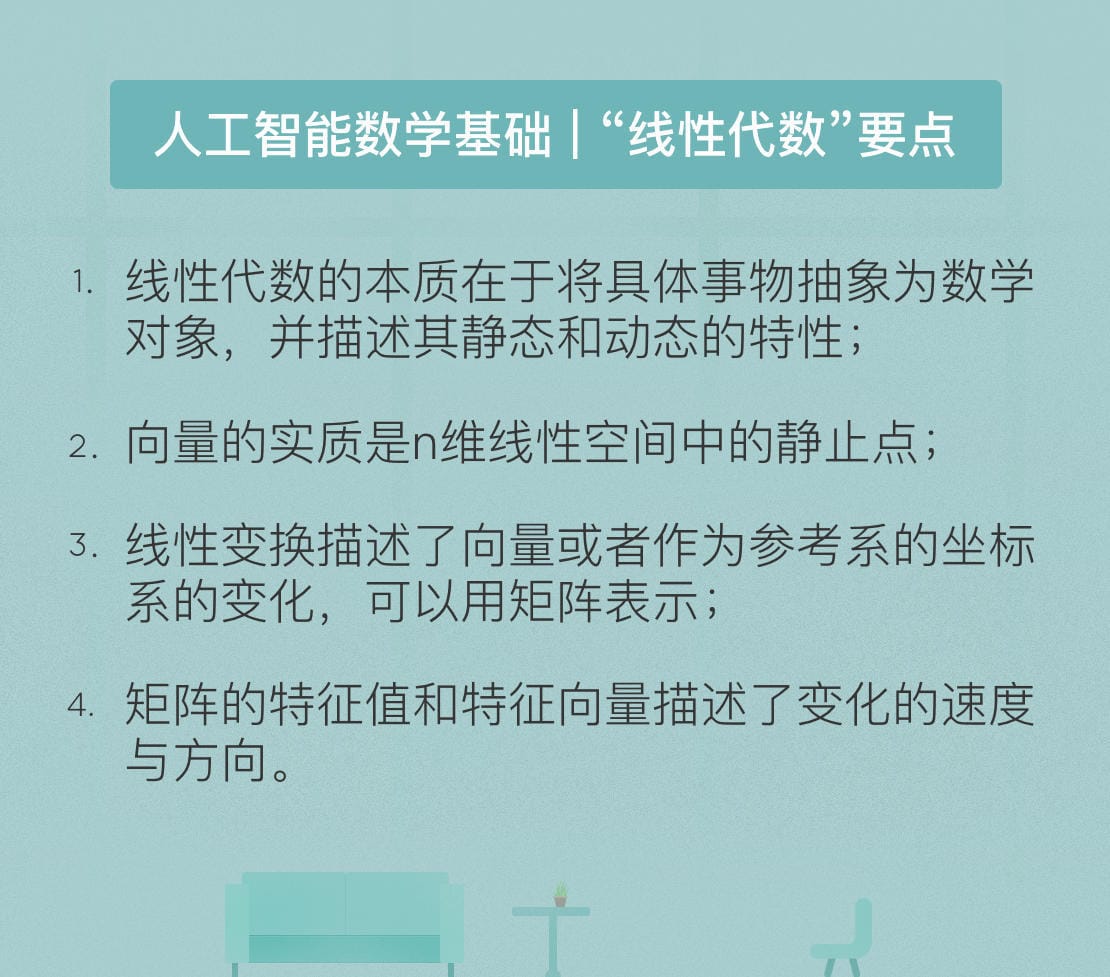

月有阴晴圆缺,此事古难全:概率论

概率论是线性代数之外,人工智能的另一个理论基础,多数机器学习模型采用的都是基于概率论的方法。但由于实际任务中可供使用的训练数据有限,因而需要对概率分布的参数进行估计,这也是机器学习的核心任务。

概率的估计有两种方法:最大似然估计法(maximum likelihood estimation)和最大后验概率法(maximum a posteriori estimation),两者分别体现出频率学派和贝叶斯学派对概率的理解方式。

概率论基础,着重于抽象概念的解释而非具体的数学公式,其要点如下:

概率论关注的是生活中的不确定性或可能性;

频率学派认为先验分布是固定的,模型参数要靠最大似然估计计算;

贝叶斯学派认为先验分布是随机的,模型参数要靠后验概率最大化计算;

正态分布是最重要的一种随机变量的分布。

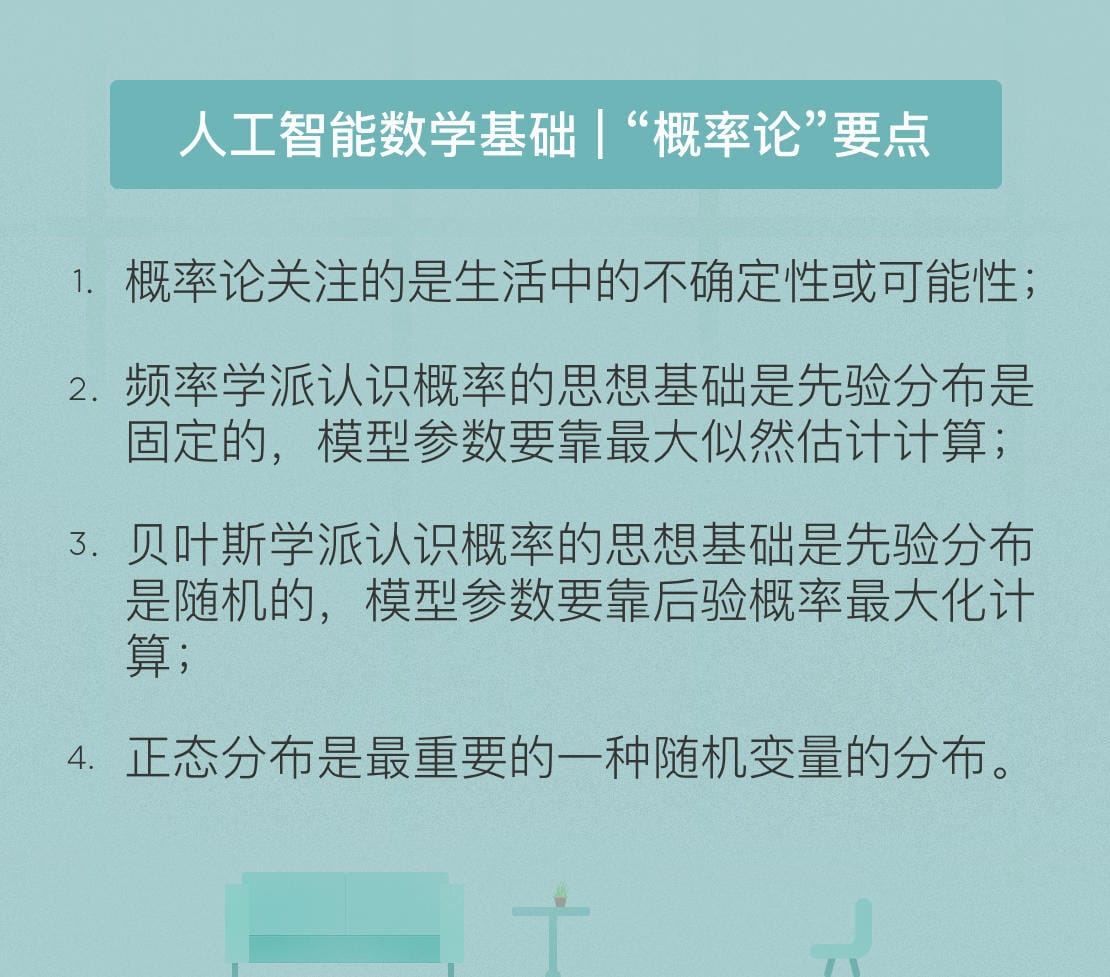

窥一斑而知全豹:数理统计

人工智能必备的数理统计基础,着重于抽象概念的解释而非具体的数学公式,其要点如下:

数理统计的任务是根据可观察的样本反过来推断总体的性质;

推断的工具是统计量,统计量是样本的函数,是个随机变量;

参数估计通过随机抽取的样本来估计总体分布的未知参数,包括点估计和区间估计;

假设检验通过随机抽取的样本来接受或拒绝关于总体的某个判断,常用于估计机器学习模型的泛化错误率。

最优化方法

人工智能必备的最优化方法基础,着重于抽象概念的解释而非具体的数学公式,其要点如下:

通常情况下,最优化问题是在无约束情况下求解给定目标函数的最小值;

在线性搜索中,确定寻找最小值时的搜索方向需要使用目标函数的一阶导数和二阶导数;

置信域算法的思想是先确定搜索步长,再确定搜索方向;

以人工神经网络为代表的启发式算法是另外一类重要的优化方法。

万物皆数,信息亦然:信息论

近年来的科学研究不断证实,不确定性才是客观世界的本质属性。换句话说,上帝还真就掷骰子。不确定性的世界只能使用概率模型来描述,正是对概率的刻画促成了信息论的诞生。

信息论使用“信息熵”的概念,对单个信源的信息量和通信中传递信息的数量与效率等问题做出了解释,并在世界的不确定性和信息的可测量性之间搭建起一座桥梁。

人工智能必备的数理统计基础,着重于抽象概念的解释而非具体的数学公式,其要点如下:

数理统计的任务是根据可观察的样本反过来推断总体的性质;

推断的工具是统计量,统计量是样本的函数,是个随机变量;

参数估计通过随机抽取的样本来估计总体分布的未知参数,包括点估计和区间估计;

假设检验通过随机抽取的样本来接受或拒绝关于总体的某个判断,常用于估计机器学习模型的泛化错误率。

明日黄花迹难寻:形式逻辑

人工智能必备的形式逻辑基础,以及采用形式逻辑进行自动推理的基本原理,其要点如下:

如果将认知过程定义为对符号的逻辑运算,人工智能的基础就是形式逻辑;

谓词逻辑是知识表示的主要方法;

基于谓词逻辑系统可以实现具有自动推理能力的人工智能;

不完备性定理向“认知的本质是计算”这一人工智能的基本理念提出挑战。

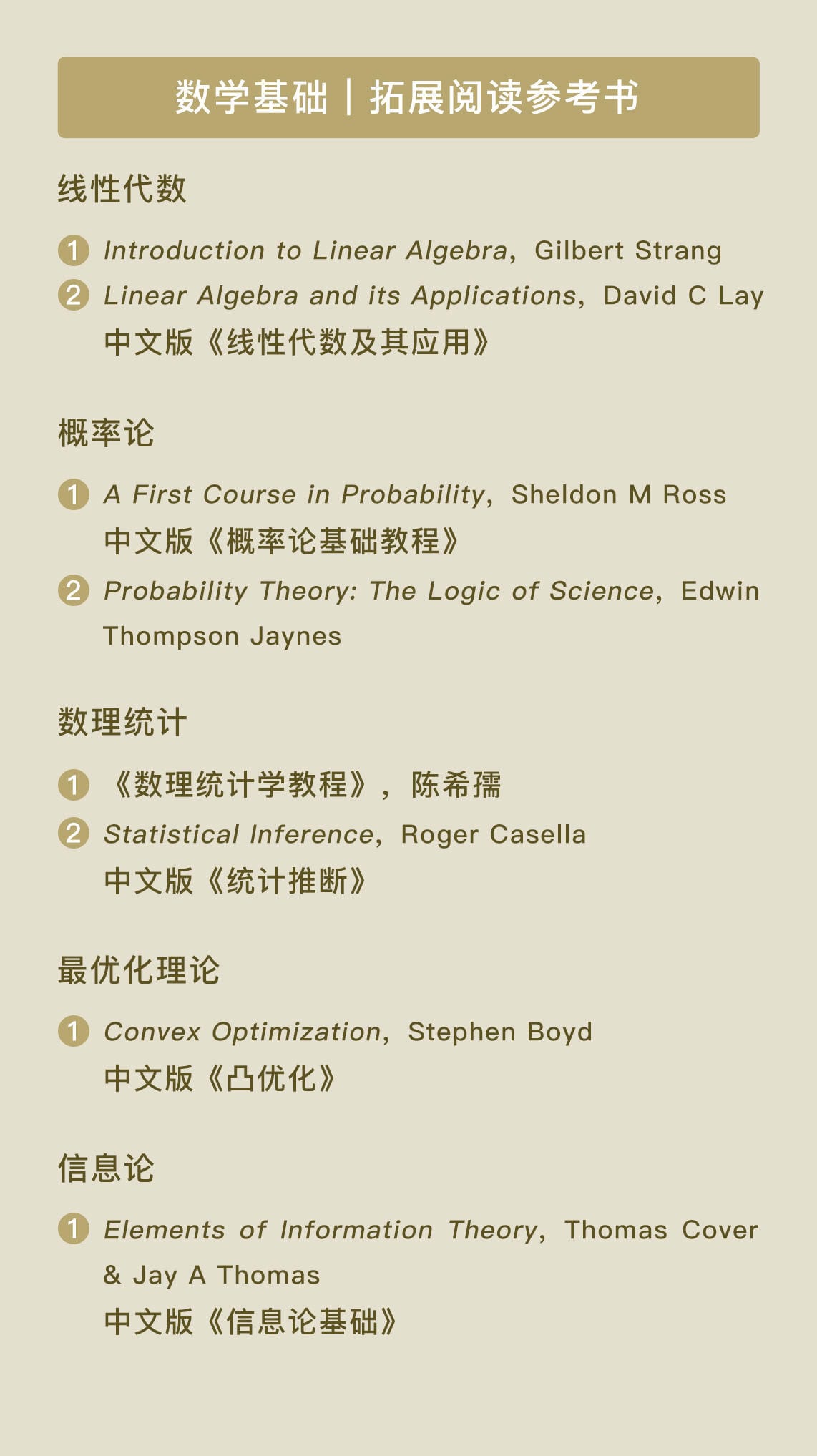

拓展阅读参考书

总结自:人工智能基础课: https://time.geekbang.org/column/62