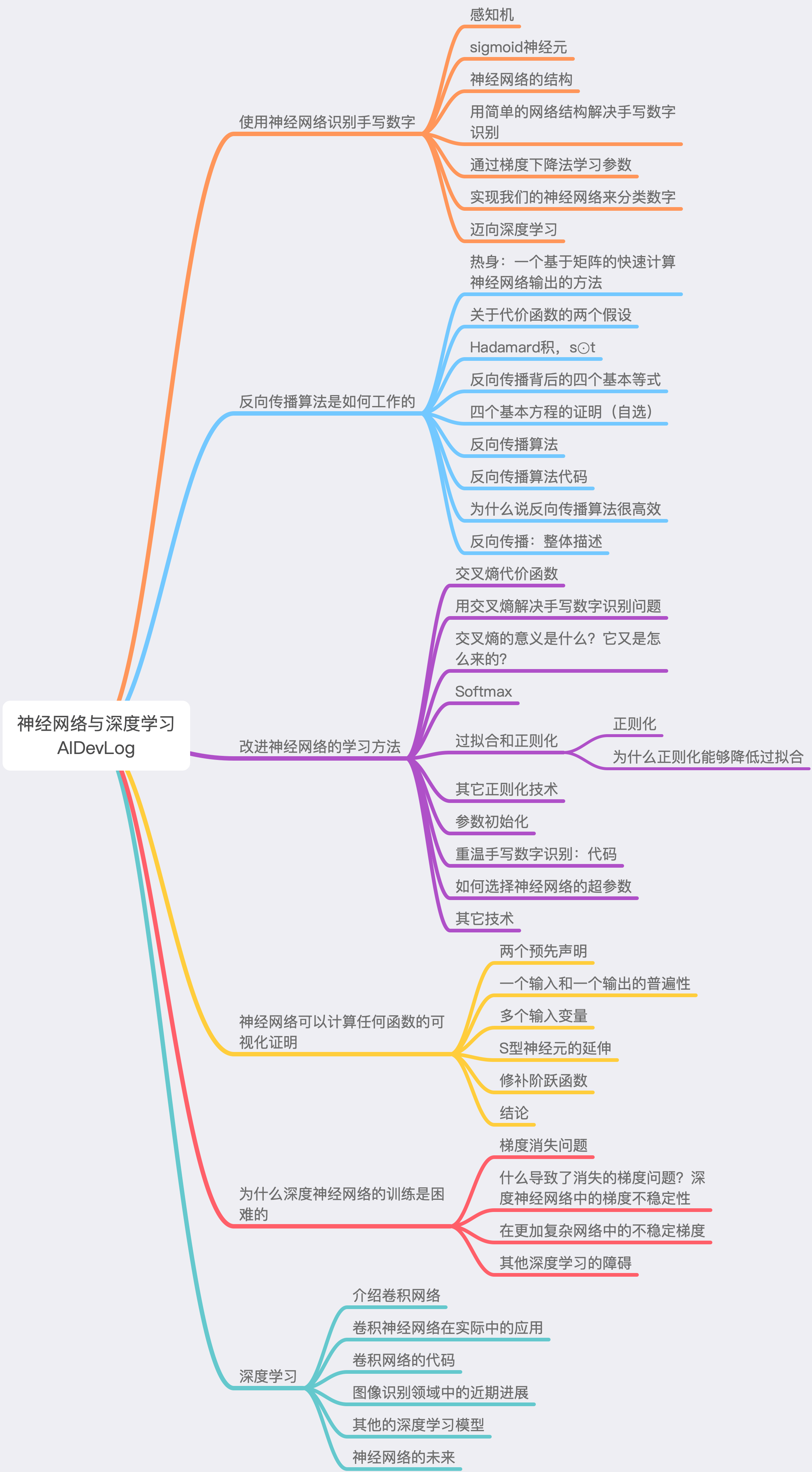

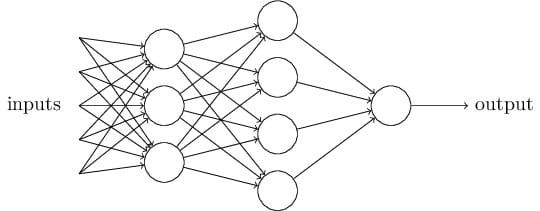

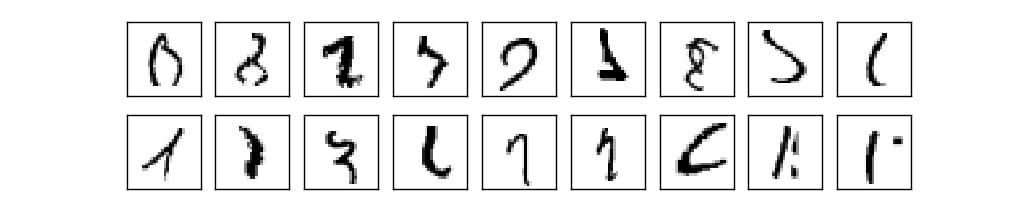

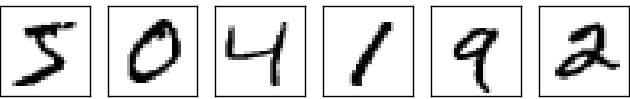

使用神经网络识别手写数字

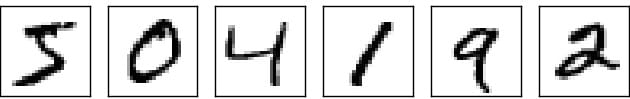

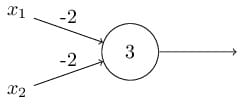

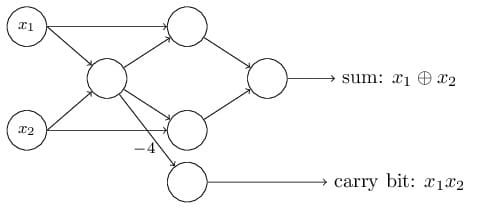

感知机

- 输入

- 输出

- 权重(weight)

- 阈值(threshold value)

偏置(bias)

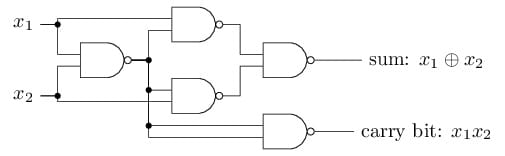

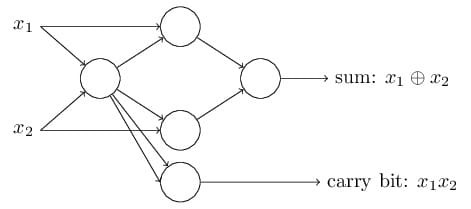

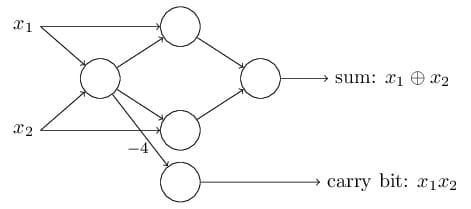

与非门 (NAND gate)

感知机网络计算任何逻辑函数

一个没有输入的感知机,那么加权和恒为 0。

所以,我们最好不要将输入感知机当做感知机,而是理解为一个特殊的单元,它能够输出我们想要的值。

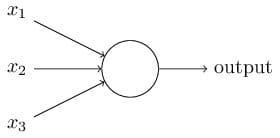

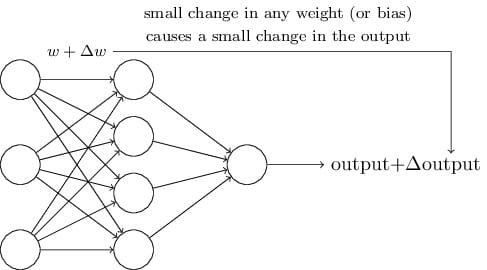

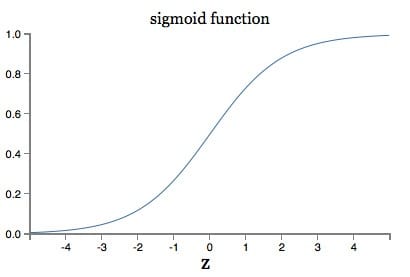

sigmoid神经元

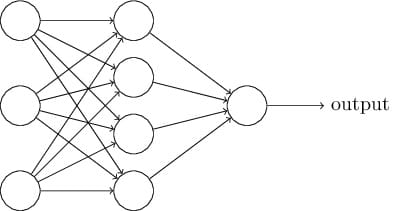

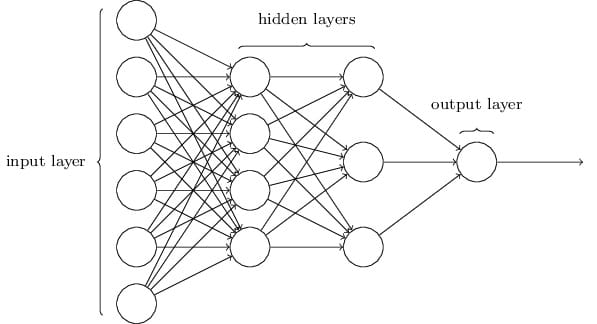

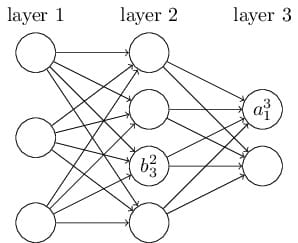

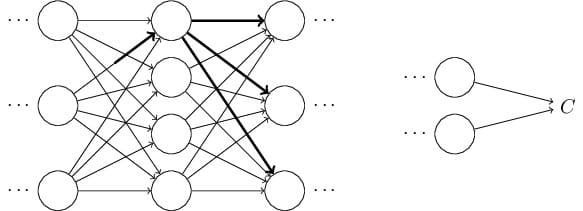

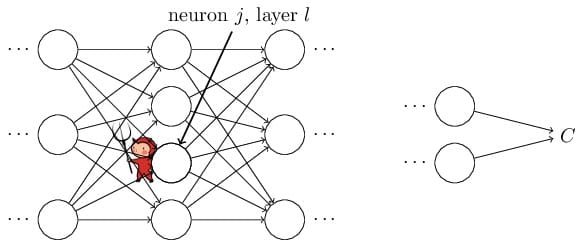

神经网络的结构

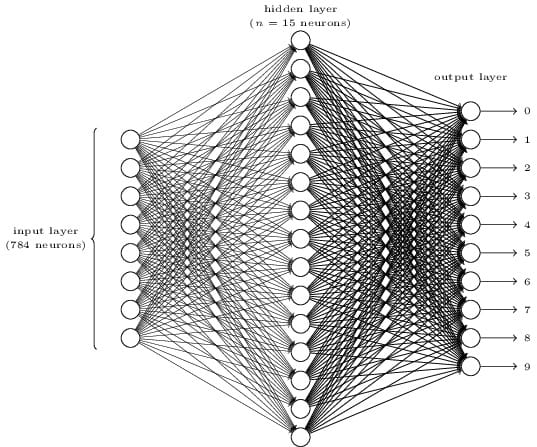

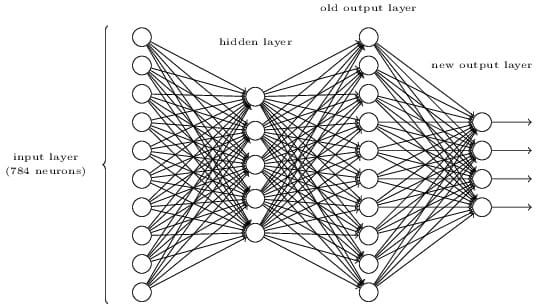

用简单的网络结构解决手写数字识别

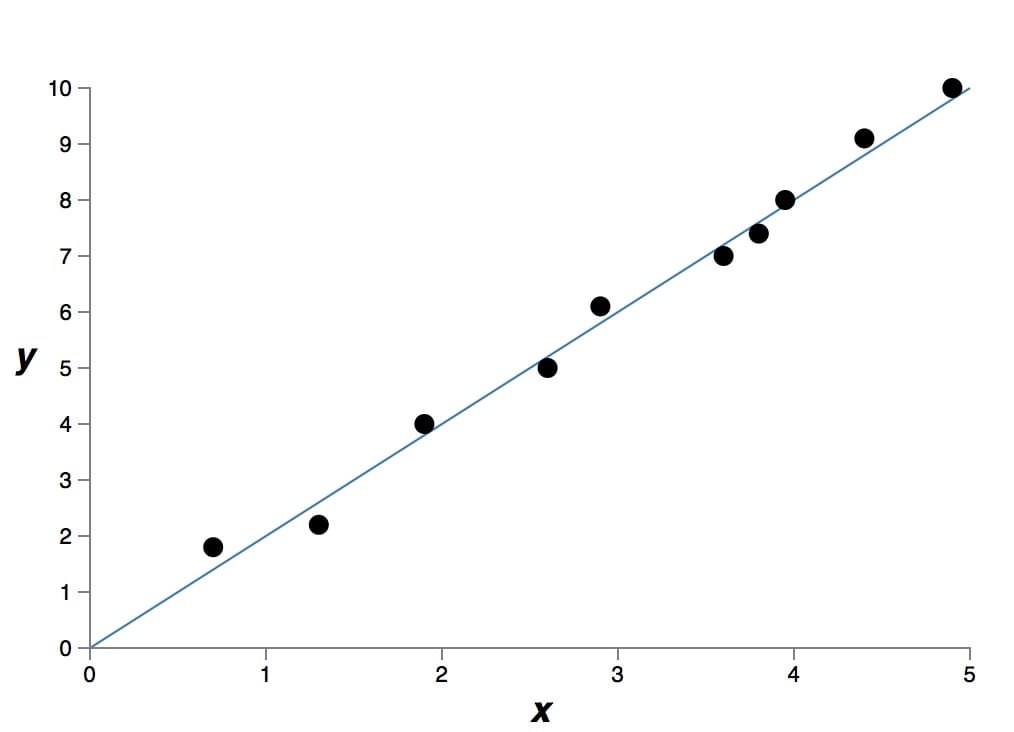

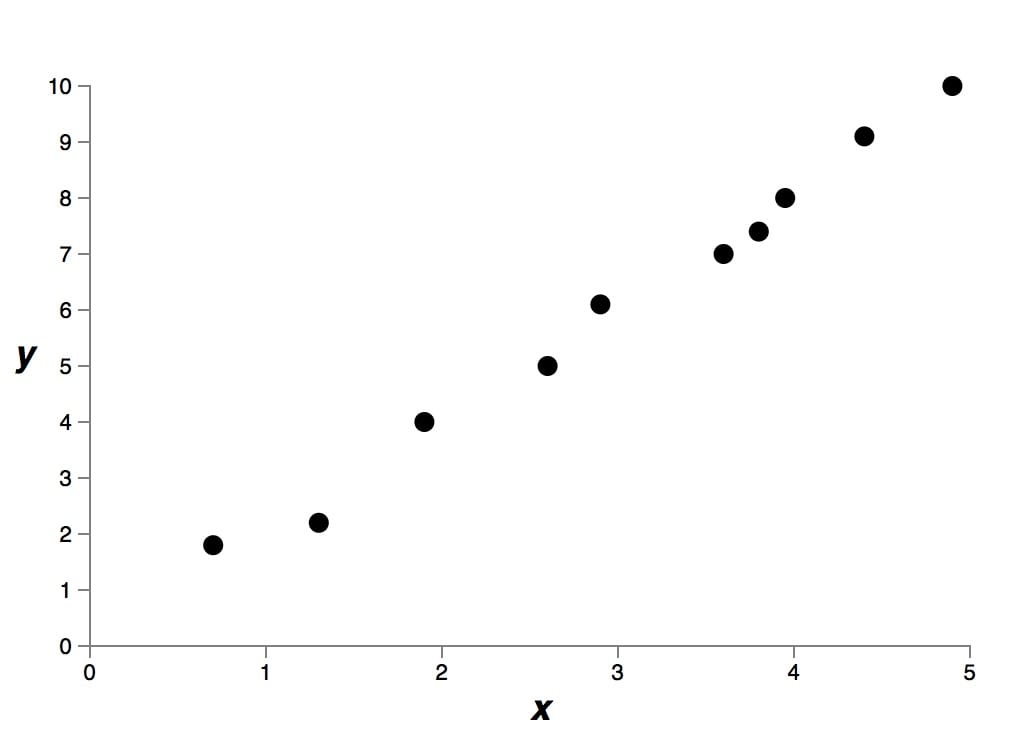

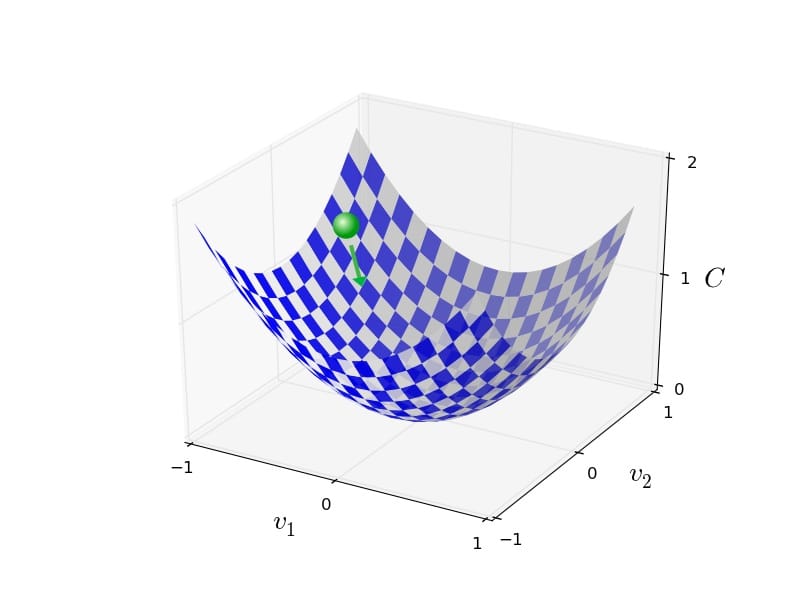

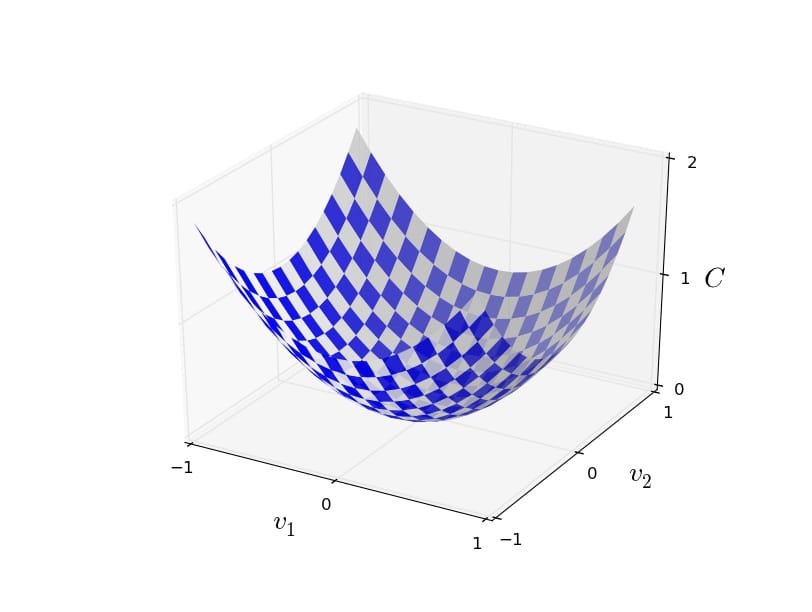

通过梯度下降法学习参数

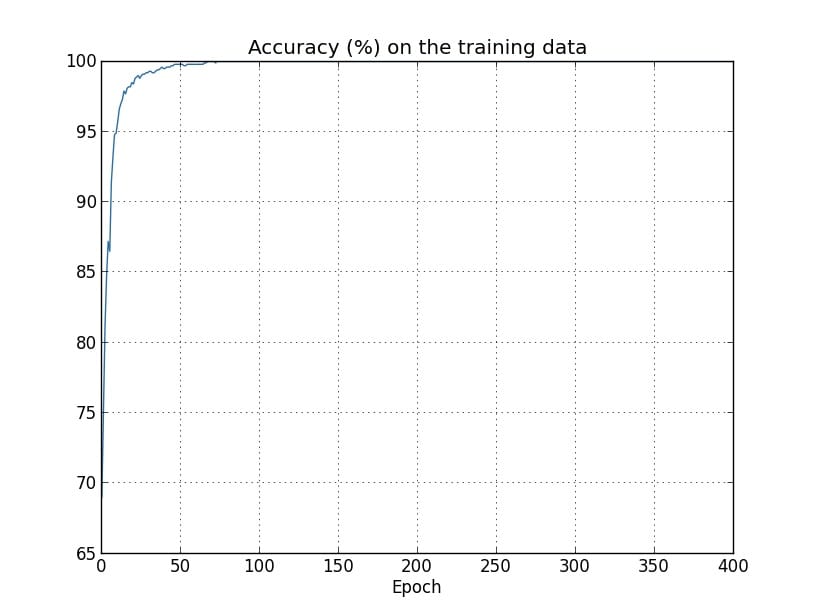

实现我们的神经网络来分类数字

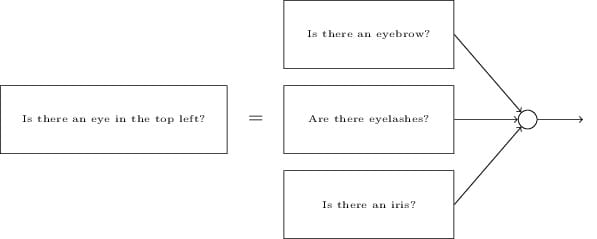

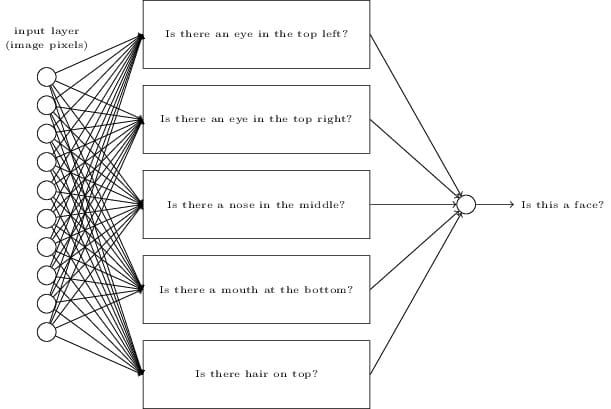

迈向深度学习

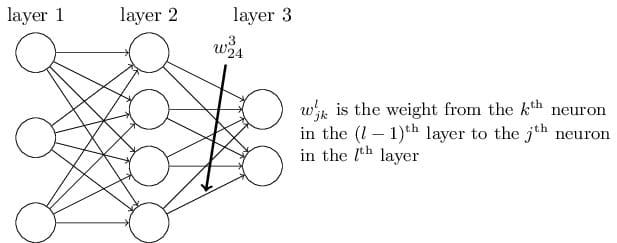

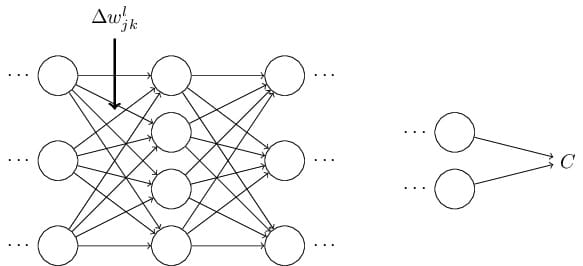

反向传播算法是如何工作的

热身:一个基于矩阵的快速计算神经网络输出的方法

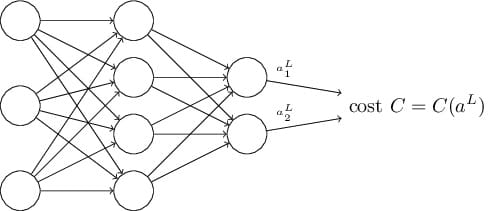

关于代价函数的两个假设

Hadamard积,s⨀t

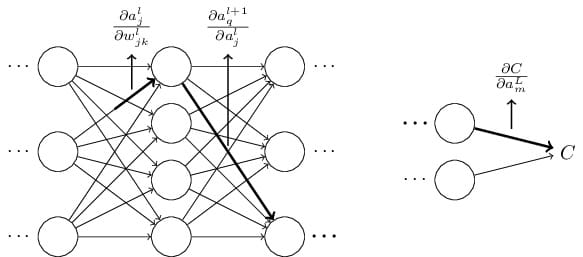

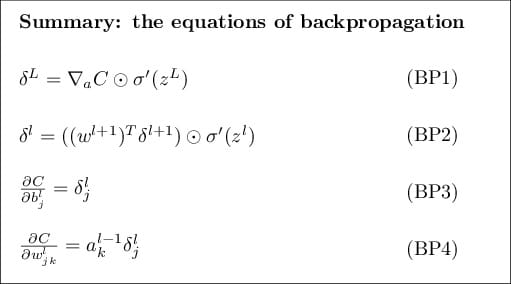

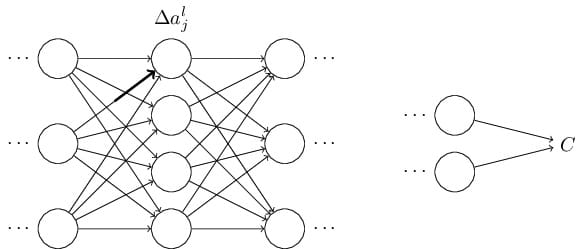

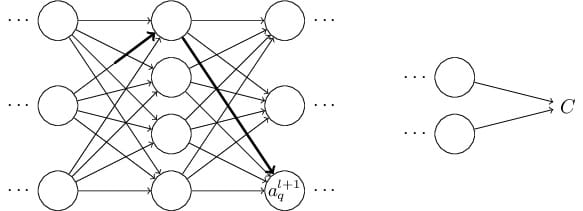

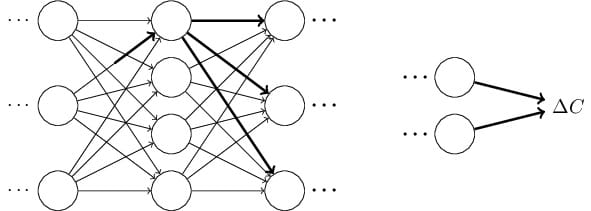

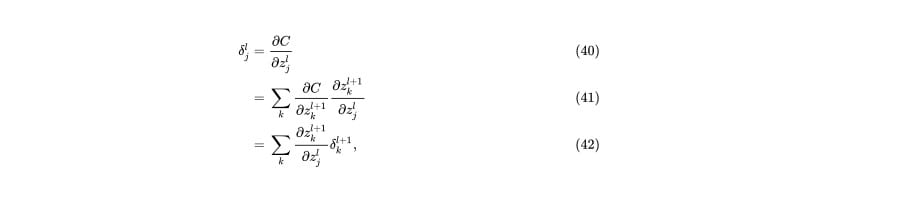

反向传播背后的四个基本等式

四个基本方程的证明(自选)

反向传播算法

反向传播算法代码

为什么说反向传播算法很高效

反向传播:整体描述

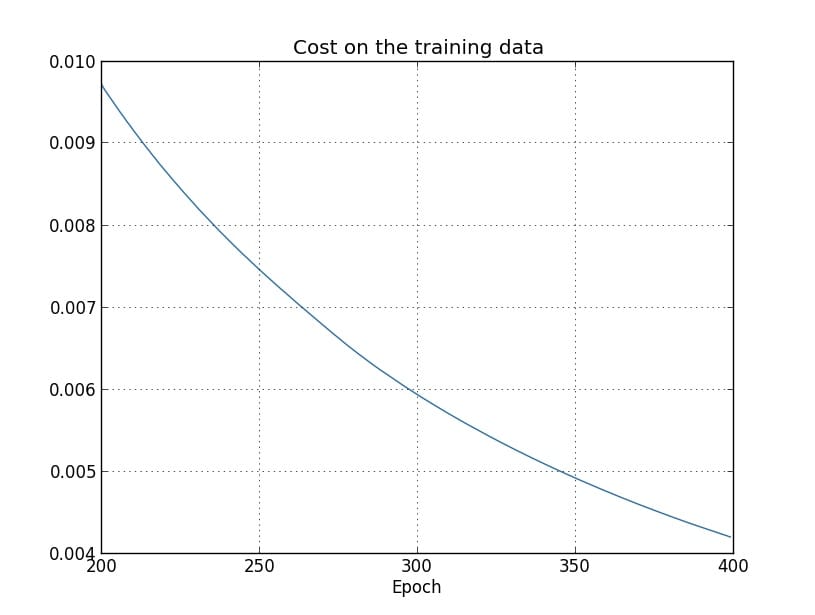

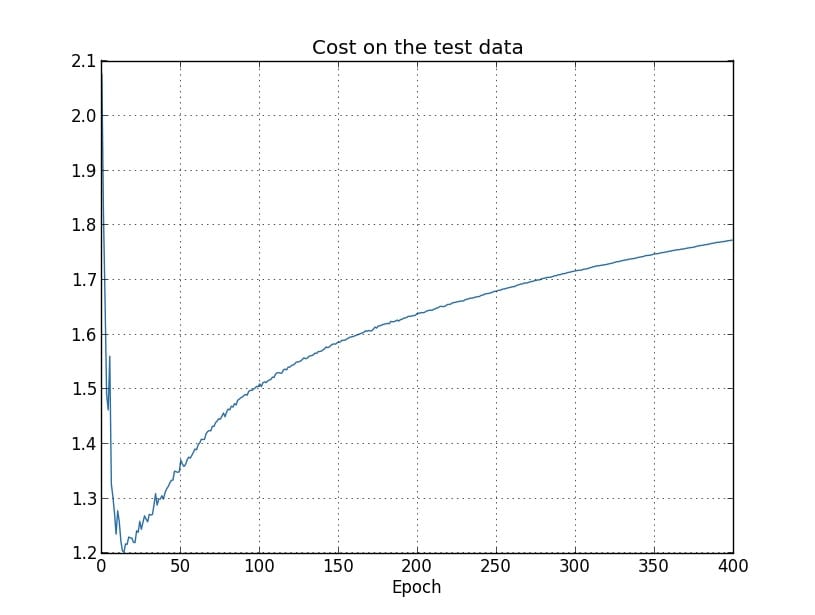

改进神经网络的学习方法

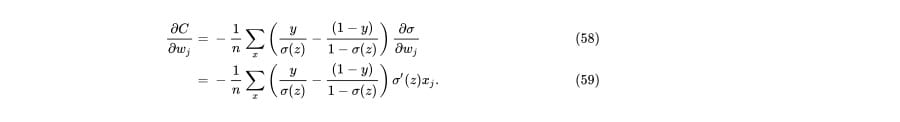

交叉熵代价函数

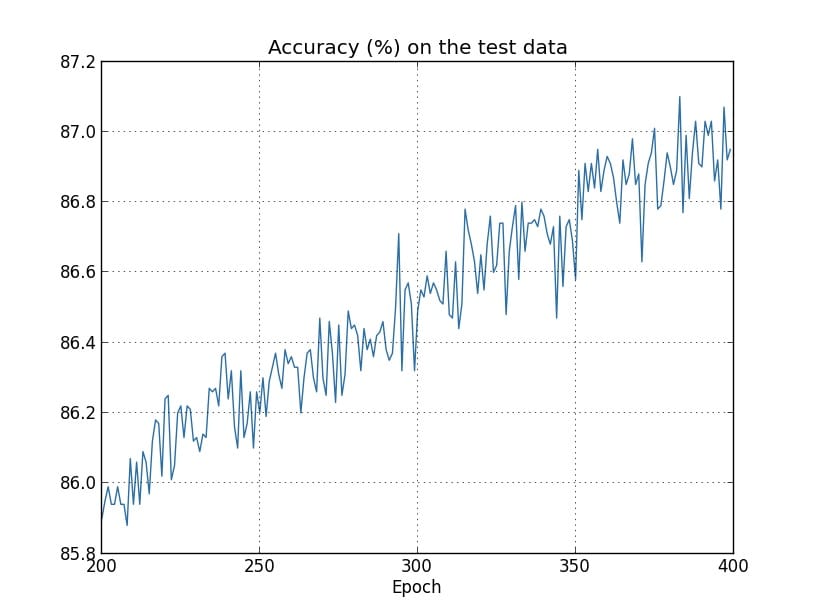

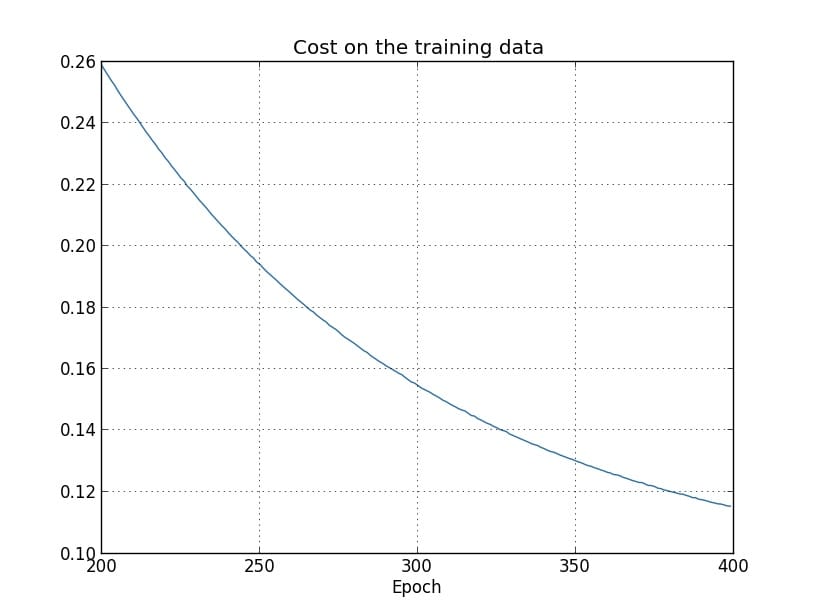

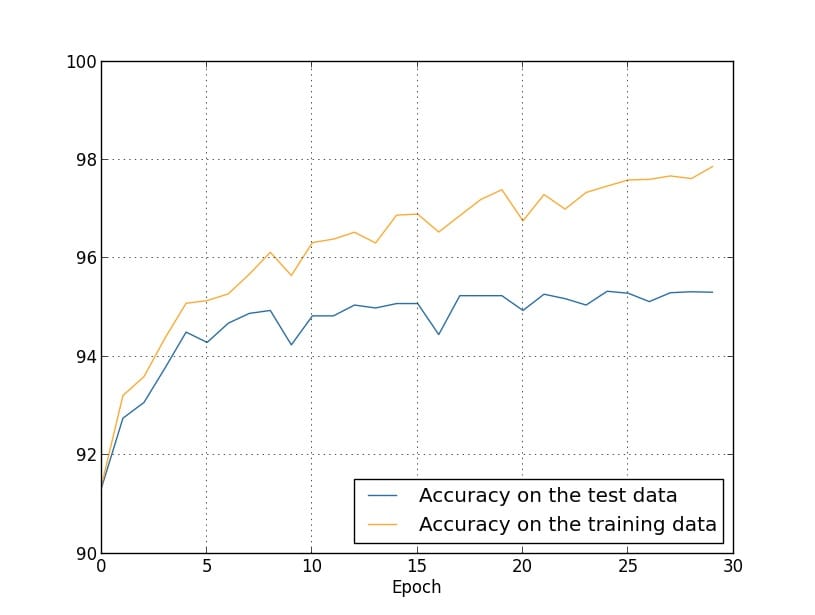

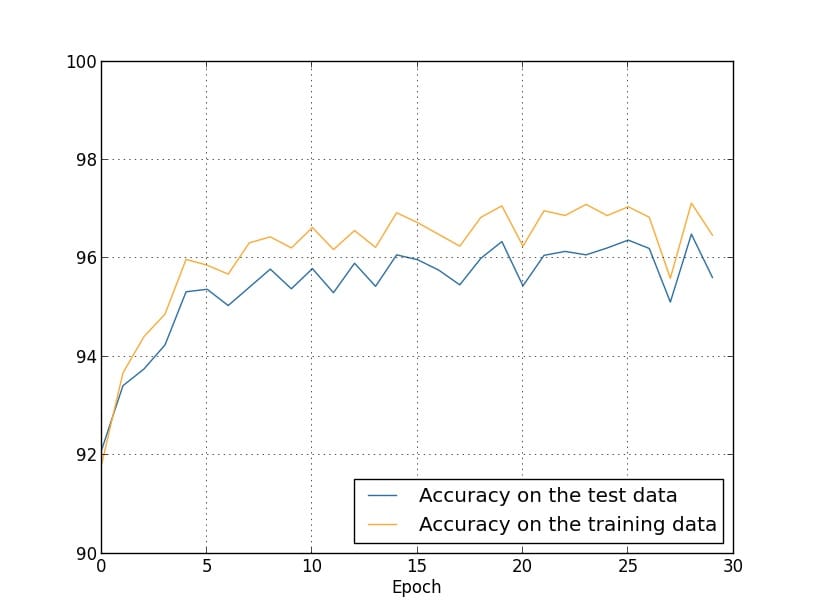

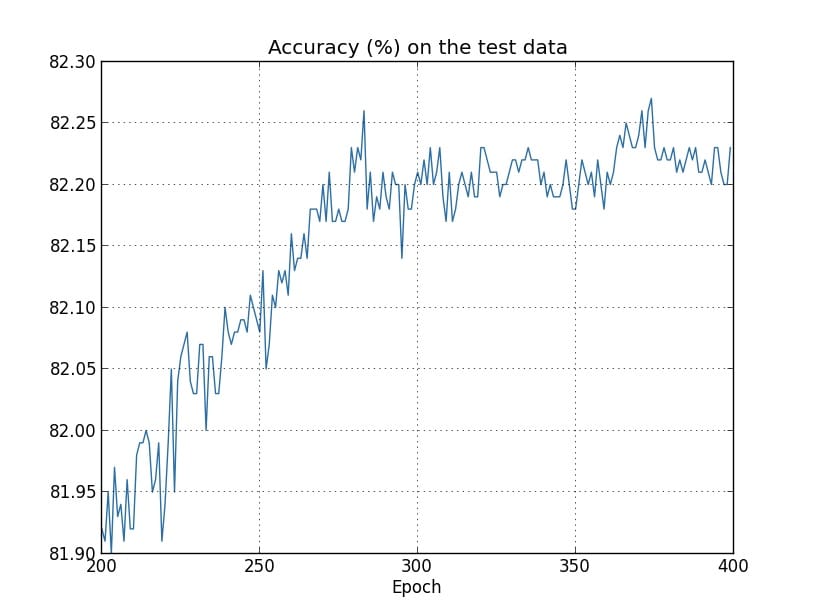

用交叉熵解决手写数字识别问题

交叉熵的意义是什么?它又是怎么来的?

Softmax

过拟合和正则化

正则化

为什么正则化能够降低过拟合

其它正则化技术

参数初始化

重温手写数字识别:代码

如何选择神经网络的超参数

其它技术

神经网络可以计算任何函数的可视化证明

两个预先声明

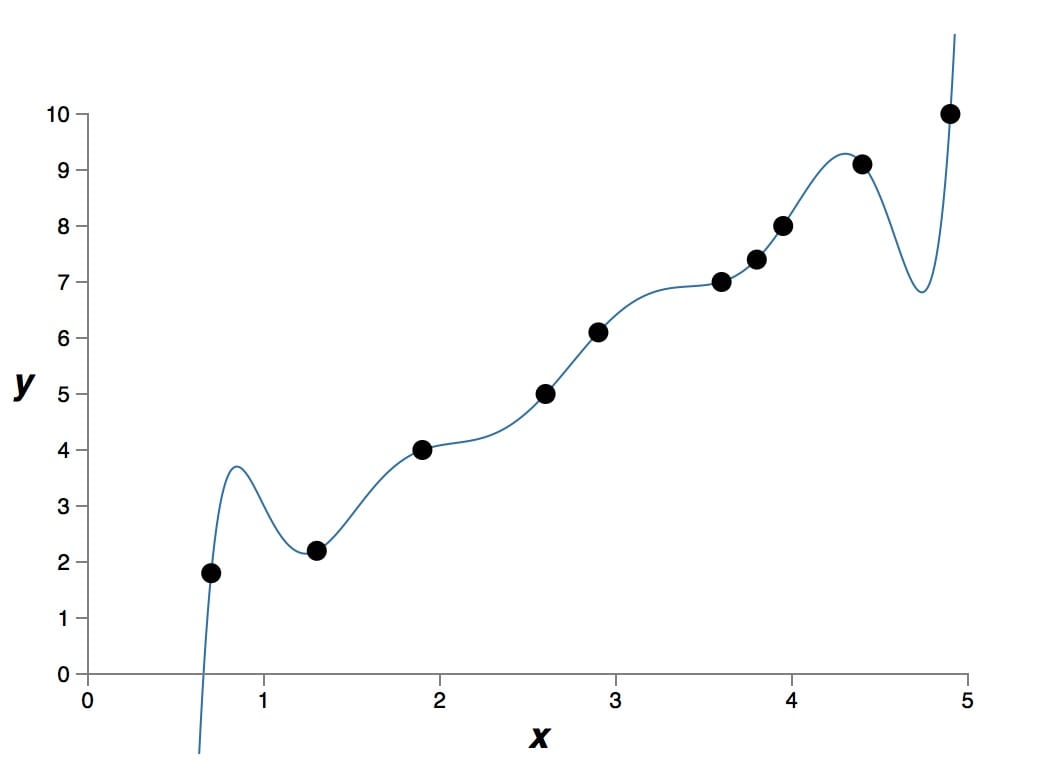

一个输入和一个输出的普遍性

多个输入变量

S型神经元的延伸

修补阶跃函数

结论

为什么深度神经网络的训练是困难的

梯度消失问题

什么导致了消失的梯度问题?深度神经网络中的梯度不稳定性

在更加复杂网络中的不稳定梯度

其他深度学习的障碍

深度学习

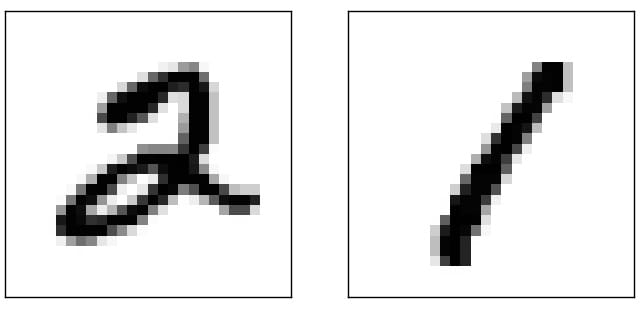

介绍卷积网络

卷积神经网络在实际中的应用

卷积网络的代码

图像识别领域中的近期进展

其他的深度学习模型

神经网络的未来

源码:https://github.com/mnielsen/neural-networks-and-deep-learning

英文:http://neuralnetworksanddeeplearning.com/

中文:https://hit-scir.gitbooks.io/neural-networks-and-deep-learning-zh_cn/content/